Il team di Opera Browser ha annunciato l'introduzione del supporto sperimentale per ben 150 varianti locali di LLM (Large Language Model). A loro volta queste ultime derivano da circa 50 famiglie di modelli. Tale novità riguarda nello specifico Opera One in versione per sviluppatori e si tratta della prima volta in assoluto in cui degli LLM locali divengono accessibili e gestibili da un browser tramite una funzionalità integrata.

New Opera AI Feature Drop:

Use browser AI with local LLMs of your choice!

This is a big deal. We’re digging deeper in the comments 👇 pic.twitter.com/kmZMYTNCA9

— Opera (@opera) April 3, 2024

I modelli generativi supportati da Opera

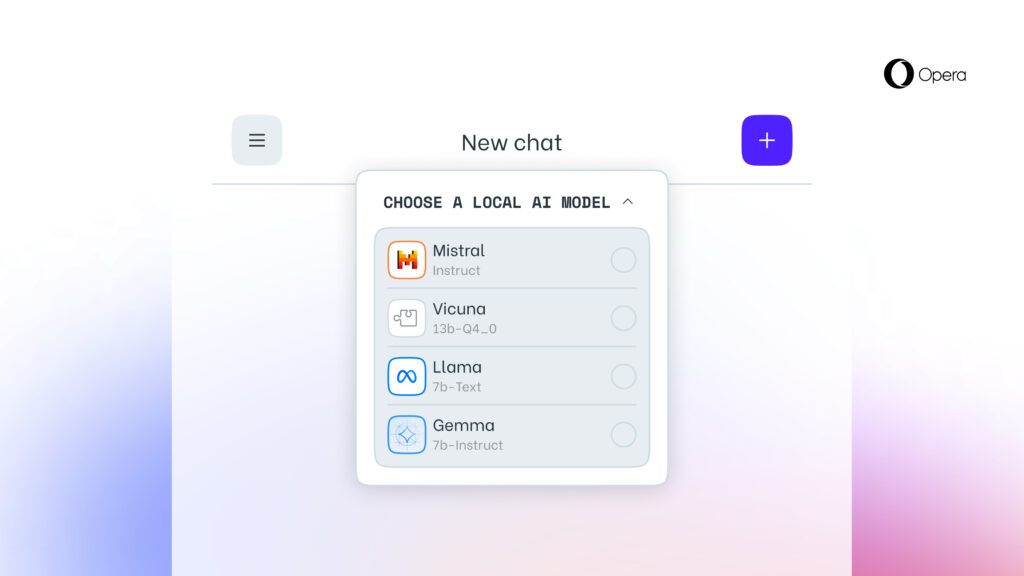

I modelli locali di Intelligenza Artificiale sono complementari alla piattaforma Aria AI di Opera. Tra di essi troviamo tutti i nomi più noti del settore come per esempio Llama di Meta, Vicuna, Gemma di Google e Mixtral di Mistral AI. Alcuni di essi sono considerati tra le migliori alternative Open Source a GPT di OpenAI e il suo ChatGPT.

I vantaggi degli LLM locali

Rispetto ad una soluzione remota, i modelli implementati localmente presentano alcuni vantaggi, tra cui dei benefici per quanto riguarda la privacy. Come per esempio il fatto che i dati inviati ad essi continuano a risiedere sul medesimo device anche dopo l'elaborazione. Nessuna informazione viene quindi passata a server di terze parti. Tale progetto viene sviluppato da Opera nel quadro dell'AI Feature Drops Program, destinato agli utenti che desiderano testare gli LLM quando sono ancora in fase sperimentale.

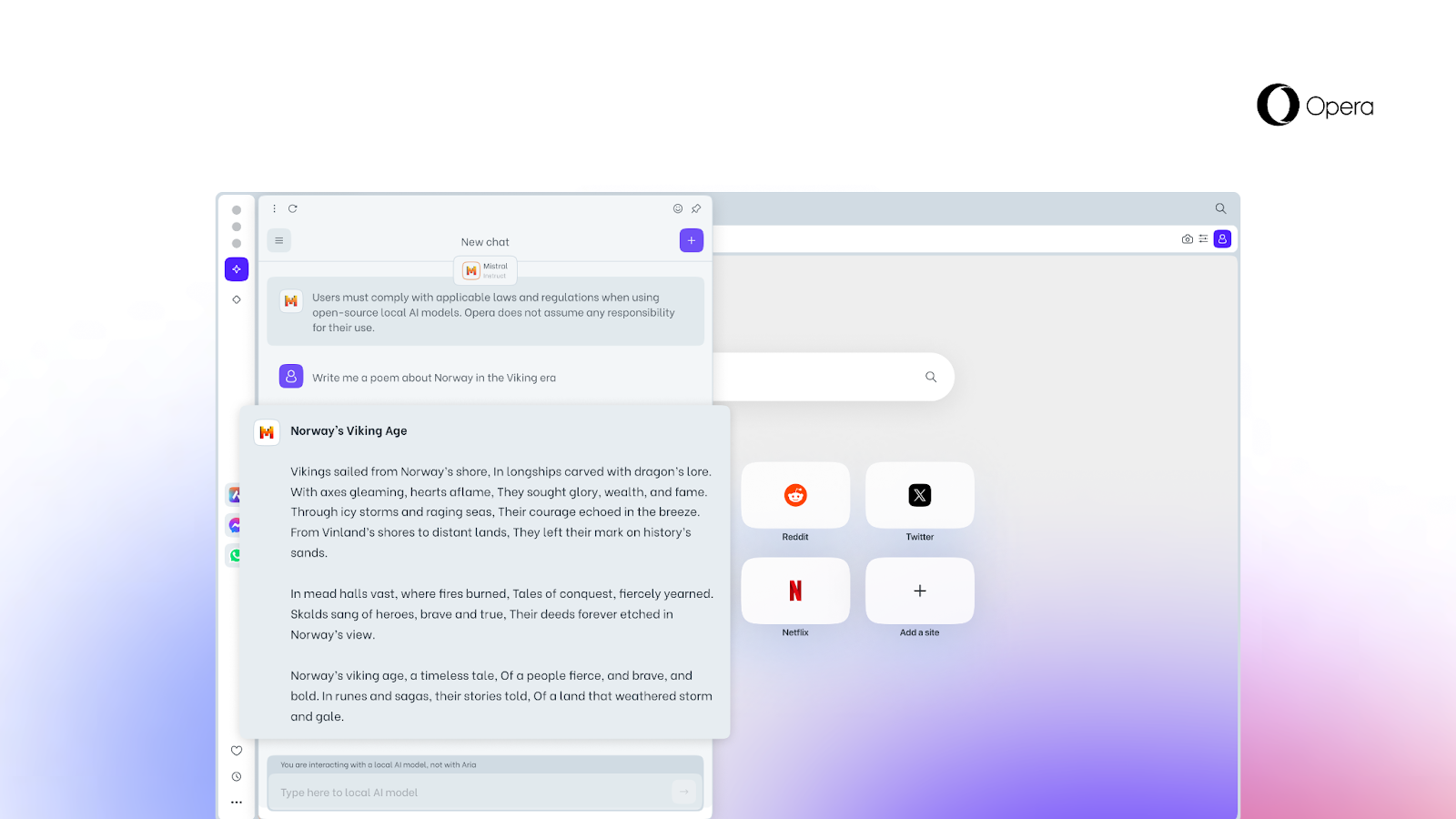

La release di Opera One per gli sviluppatori permette di selezionare il modello che si vuole utilizzare. Una volta scelto il modello esso dovrà essere scaricato nel proprio terminale, tenendo conto che generalmente i loro package possono occupare tra i 2 e i 10 GB di spazio su disco. In alcuni casi si potrebbero osservare dei rallentamenti rispetto alle soluzioni server side. Questo però dipenderà dalle caratteristiche del proprio hardware più che dal modello di riferimento.

È possibile utilizzare uno degli LLM supportati al posto di Aria AI ma sarà sempre possibile impostare nuovamente quest'ultimo come chatbot di default.

Opera e Code Llama

Tra i modelli disponibili troviamo anche un'estensione di Llama per la generazione e la revisione del codice, Code Llama, con focus sull'accelerazione delle sessioni di coding. Esso è disponibile in tre versioni: con 7, 13 e 34 miliardi di parametri. Supporta inoltre diversi linguaggi di programmazione tra cui Python, C++, Java, PHP, Typescript (JavaScript), C# e Bash.

/https://www.html.it/app/uploads/2024/04/opera.png)

/https://www.html.it/app/uploads/2024/05/Oracle.png)

/https://www.html.it/app/uploads/2024/05/OpenAI.jpg)

/https://www.html.it/app/uploads/2024/05/Microsoft-4.jpg)

/https://www.html.it/app/uploads/2024/05/YouTube-Music.jpg)